Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

米スタンフォード大学と米MIT(Massachusetts Institute of Technology)、米Autodesk AI Labの研究チームが開発した「Translating a Visual LEGO Manual to a Machine-Executable Plan」は、LEGOの組み立て説明書(画像ベースのステップバイステップの組み立てマニュアル)をロボットでも理解できる機械語に変換する学習ベースのモデルだ。

LEGOの組み立て説明書は、人間が見て組み立てられるように1つ1つの手順が順番通りに記されており、本もしくはPDFなどで提供されている。コンピュータビジョンが発展している昨今だが、この組み立て説明書を入力してもロボットがLEGOを組み立てることはできない。

そこで研究チームは、ロボットでも組み立て説明書から組み立てられるように、組み立て手順を機械が解釈可能な命令に変換するモデルの構築に取り組んだ。

この課題を実現するには、組み立て説明書に2次元で記されている各部品の3次元方向と配置を、場合によってはオクルージョンの存在も含めて予測しなければならない。さらにLEGOは部品が豊富なため、データベースにない未見の部品にも対応しなければならない。

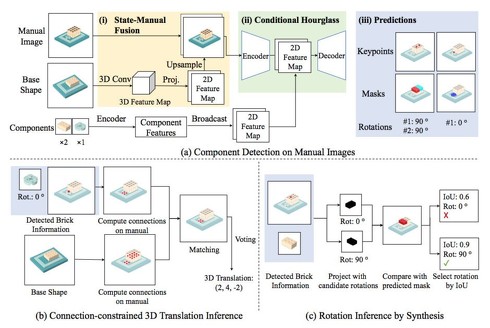

これらに対応するため、組み立て説明書の画像から機械が理解できる組み立てステップを再構築する、新しい学習ベースのフレームワーク「MEPNet」(Manual-to-Executable-Plan Network)を提案する。

MEPNetは2つのステージからなる。第1段階では、組み立て説明書から2D部品の形状など全ての構成要素を入力し、2次元キーポイントとマスクのセットを畳み込みニューラルネットワークで予測する。第2段階では、第1段階で予測された情報からベース形状と新しい部品の間の可能な接続を見つけることによって各部品の3次元姿勢を推定する。

今回提案するMEPNetは、LEGOに限定される技術ではなく、例えばMinecraftや家具などの何かを組み立てる説明書に適応できる。

そのためMEPNetの性能を評価するために、LEGOとMinecraftの家作りの2つのベンチマークを用意し試した。その結果、MEPNetは複数のベースラインと比較して、より正確な3D姿勢推定を可能にし、また未見の新しい3D部品に対してもより良く汎化できることを示した。

Source and Image Credits: Wang, Ruocheng, Yunzhi Zhang, Jiayuan Mao, Chin-Yi Cheng, and Jiajun Wu. “Translating a Visual LEGO Manual to a Machine-Executable Plan.” arXiv preprint arXiv:2207.12572 (2022).

関連記事

関連リンク

からの記事と詳細 ( LEGOの説明書を読んで組み立てるAI、米スタンフォード大などが開発 家具やMinecraftでも応用可能 - ITmedia NEWS )

https://ift.tt/sgVFX6G

No comments:

Post a Comment